Découvrir vllm : guide complet pour comprendre cette technologie en 2025

L’essentiel à retenir

📖 Lecture : 10 min

Ce que vous devez savoir sur vLLM pour réussir.

Salut ! Aujourd’hui, on va parler de vLLM, une technologie révolutionnaire qui transforme radicalement notre interaction avec l’intelligence artificielle. En intégrant à la fois la compréhension du langage naturel et la vision par ordinateur, les modèles vision-langage (vLLM) promettent des avancées majeures dans de nombreux domaines, de la recherche à l’éducation, en passant par le secteur des médias. Comment cette technologie fonctionne-t-elle ? Quelles sont ses implications pour les développeurs et les entreprises en 2025 ? Explorons-le ensemble.

Les fondamentaux des modèles de langage visuel

Pour mieux appréhender les vLLM, il est crucial de comprendre ce que cela implique. Les vLLM associent deux domaines technologiques majeurs : le traitement du langage naturel (NLP) et la vision par ordinateur. Cette combinaison permet aux machines de comprendre et d’interpréter à la fois le texte et les images, ouvrant ainsi de nouvelles voies pour interagir avec les données.

L’architecture des vLLM

À la base, les vLLM utilisent des architectures de type transformateur comme celles populaires auprès des modèles de langage tels que BERT ou GPT. Ces architectures sont optimisées pour traiter de grandes quantités de données textuelles et visuelles. Grâce à une attention paginée, les vLLM peuvent gérer des flux d’informations complexes, rendant leur utilisation particulièrement efficace pour des tâches de traitement en temps réel.

Les vLLM exploitent également la notion de contextes étendus, générant des résultats plus cohérents en prenant en compte non seulement les mots, mais aussi leur contexte visuel, ce qui est essentiel pour des applications telles que la génération de légendes pour les images ou la compréhension de vidéos.

- 🎨 Transformateurs : Utilisation des architectures avancées pour le traitement du langage et des images.

- 📈 Attention paginée : Permet une gestion efficace des séquences et un suivi contextuel approfondi.

- 🌐 Applications multi-domaines : De la traduction à la génération de contenu, les vLLM sont polyvalents.

Applications pratiques des vLLM

Les applications des vLLM sont variées et impactent de nombreux secteurs. Voici quelques exemples marquants :

- 📝 Génération de contenu : Création de textes accompagnés de médias, adaptée aux besoins spécifiques des utilisateurs.

- 📽️ Analyse vidéo : Compréhension et résumé des vidéos, facilitant la tâche pour les plateformes de streaming.

- 🩺 Santé : Aide à l’interprétation des images médicales en relation avec des rapports écrits.

Ces capacités font des vLLM un outil précieux pour les entreprises qui cherchent à innover et à améliorer leur efficacité opérationnelle. Les chiffres parlent d’eux-mêmes, avec des modèles comme Llama3.1 comptant plus de 400 milliards de paramètres, rendant leur puissance de traitement quasi inégalée.

Fonctionnement interne des vLLM

Pour saisir pleinement le potentiel des vLLM, il est essentiel d’explorer leur fonctionnement interne. Les vLLM prennent en charge l’inférence en streaming, ce qui signifie qu’ils peuvent traiter les informations en temps réel. Cela améliore non seulement la vitesse de réponse, mais réduit également la latence, un facteur crucial dans les applications sensibles au temps.

Optimisation des ressources

Les vLLM utilisent des techniques avancées d’optimisation de la mémoire, comme la quantification et la gestion dynamique des ressources. Cela signifie qu’ils peuvent fonctionner efficacement même dans des environnements à ressources limitées. Cependant, il est essentiel de noter que des exigences en matière de puissance de calcul peuvent limiter leur utilisation, nécessitant souvent des GPU puissants comme ceux proposés par NVIDIA.

Caractéristiques clés des vLLM

| Caractéristique | Description | Impact |

|---|---|---|

| Inférence en streaming | Traitement des données en temps réel | Améliore la réactivité des applications |

| Quantification | Réduction de l’empreinte mémoire | Accroît l’efficacité de déploiement |

| Gestion dynamique | Optimisation de l’utilisation des ressources | Rend les modèles viables sur des plateformes à faibles ressources |

Ces caractéristiques montrent que les vLLM ne sont pas seulement performants mais aussi adaptables, capable de répondre aux défis actuels du traitement des données associant texte et visuel.

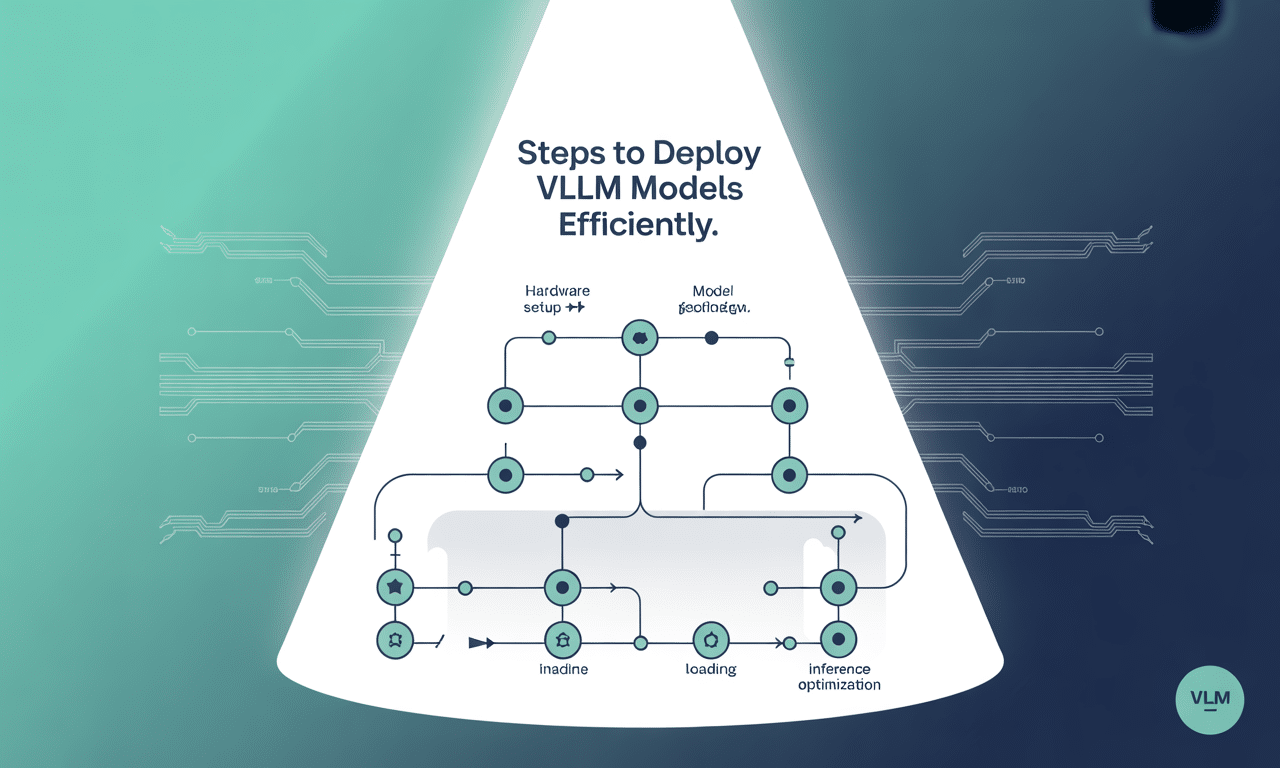

Déployer des vLLM de manière efficace

Déployer un modèle vLLM de manière efficace requiert une approche structurée. Voici les étapes clés pour garantir un déploiement réussi :

- 🔧 Configuration de l’environnement : Installez Python et les bibliothèques nécessaires comme torch et transformers.

- 📥 Chargement du modèle : Utilisez l’interface fournie pour charger le modèle de votre choix.

- ⚙️ Configuration du modèle : Adaptez les paramètres selon les besoins spécifiques de votre application.

- 🖥️ Inférence et déploiement : Utilisez des frameworks comme Flask ou FastAPI pour créer une interface utilisateur.

Si vous envisagez une intégration plus avancée, envisagez d’utiliser une API comme celle de Novita AI qui propose une solution prête à l’emploi pour le déploiement de vLLM, facilitant ainsi l’implémentation des capacités d’IA sans nécessiter des ressources matérielles lourdes en interne.

Impact futur des vLLM sur les industries

Les vLLM affirment déjà leur présence et leur impact sur le futur de l’IA. Ils ouvrent des possibilités sans précédent dans le traitement des données, favorisant des innovations qui transforment les entreprises modernes. À l’horizon, les vLLM continueront d’évoluer, améliorant leurs capacités de compréhension et d’intégration des contextes à travers les langages mutuels des textes et des images.

Révolution dans le traitement des informations

Imaginez une période où les entreprises ne seront plus limitées par la disponibilité des données visuelles ou textuelles. Les vLLM permettront une intégration fluide de ces deux types d’informations, conduisant à des systèmes d’assistance toujours plus intelligents. Par exemple :

- 🤖 Assistant personnel : Un assistant virtuel capable de comprendre le contexte d’une conversation tout en analysant des documents graphiques simultanément.

- 📊 Analyse de marché : L’analyse d’importantes quantités d’images de produits et de données textuelles peut maintenant être réalisée rapidement et efficacement.

- 🔍 Recherche améliorée : Les moteurs de recherche pourraient intégrer les résultats visuels et textuels, rendant les recherches plus intuitives.

Éthique et considérations autour des vLLM

Avec les capacités impressionnantes des vLLM viennent des responsabilités. Les questions éthiques concernant la confidentialité, les biais et les abus technologiques doivent être mises en avant.

Considérations éthiques importantes

- ⚖️ Confidentialité des données : Comment garantir la protection des données personnelles utilisées pour l’entraînement des modèles ?

- 🌀 Bias dans les données : Comment éviter que les biais présents dans les données d’entraînement ne contaminent les résultats ?

- 🚫 Abus technologique : Quels mécanismes peuvent être mis en place pour éviter les usages malintentionnés des vLLM ?

Ces préoccupations doivent être au cœur des discussions sur l’avenir des vLLM. Les entreprises et les chercheurs doivent travailler ensemble pour établir des normes éthiques qui guident le développement et l’utilisation de ces technologies avancées.

Les questions que vous vous posez vraiment. Oui, vLLM supporte les modèles quantifiés, ce qui permet de réduire l’empreinte mémoire et d’améliorer l’efficacité de l’inférence. Oui, un GPU capable de supporter des capacités de calcul élevées est nécessaire, comme les séries V100 ou A100 de NVIDIA. Il n’y a pas de réponse unique, mais des modèles tels que Llama 3.1 et Gemma 2 se distinguent par leurs performances. Oui, vLLM est conçu pour traiter efficacement les requêtes par lots et peut les gérer rapidement après une requête initiale. De nombreuses entreprises, notamment dans le secteur technologique, comme Meta AI, Google AI et Microsoft Azure, explorent l’usage de vLLM pour améliorer leurs produits.Vos questions, mes réponses simples

Est-ce que vLLM prend en charge les modèles quantifiés ?

Est-ce que vLLM nécessite une configuration GPU spécifique ?

Quels sont les meilleurs modèles de classificateurs pour vLLM ?

Peut-on utiliser vLLM pour du traitement par lots ?

Quelles sont les entreprises qui adoptent vLLM ?